[새벽 1시의 AI] 11월 13일 AI 소식 - 2025-11-13

📄 오늘의 요약

AI 관련 주요 키워드로 검색된 최근 인기 YouTube 영상들을 요약한 것입니다.

📝 상세 내용

2025년 11월 13일 새벽 1시의 소식

이 문서는 AI 관련 주요 키워드로 검색된 최근 인기 YouTube 영상들을 요약한 것입니다.

📌 오늘 뉴스레터를 읽고 나면..

- 빅테크들이 AI 개발에 목숨 거는 이유인 비용 구조와 경쟁 우위 확보 전략, API·프롬프트·데이터 접근성의 중요성을 이해할 수 있어요.

- 중국 K2 모델이 성능·비용 균형으로 글로벌 LLM 경쟁에서 우위를 차지한 배경과 의료 등 실제 응용 가능성을 알 수 있어요.

- AI를 ‘버블’이 아닌 산업 전환점으로 보는 투자 관점과 미국의 대규모 전략, 칩·데이터센터·전력 인프라에서의 경쟁 포인트를 파악할 수 있어요.

- n8n의 Guardrails 노드가 AI 자동화 과정에서 PII·악성 URL 등 위험을 사전 탐지·차단해 실무 보안을 강화하는 방법을 배울 수 있어요.

- Abacus의 deep agent가 2026년까지 어떤 업무들을 자율화할지와 이에 대비한 업무 재설계 및 자동화 수용 전략을 알 수 있어요.

다 읽으면 이것보다 더 많답니다!

🟣 99%가 모르는 빅테크 회사들이 AI개발에 목숨 거는 진짜 이유 - 김대식 교수 2부 '20분 AI 과외'

🟣 99%가 모르는 빅테크 회사들이 AI개발에 목숨 거는 진짜 이유 - 김대식 교수 2부 '20분 AI 과외'

📋 3줄 요약

• 빅테크 회사들이 AI 개발에 목숨 거는 이유는 비용 구조와 경쟁 우위를 확보하기 위해서예요.

• 대규모 모델 학습과 배포는 API 연동과 프롬프트 설계, 데이터 접근성을 확보하는 등 여러 복잡한 과정을 필요로 하네요.

• 실제 적용 목적에 따라 투자 방향을 결정하는 것이 중요하며, 고객 응대 챗봇 템플릿 같은 실용적 사례를 통해 적용해볼 수 있어요.

📖 자세한 내용 최근 빅테크 회사들에서 신규 AI 서비스를 선보였어요. AI 개발과 비즈니스 적용에 관심 있는 분이라면, 왜 빅테크들이 그토록 많은 자원과 인력을 투입하는지 궁금하실 텐데요. 빅테크가 갑자기 신규 AI 서비스를 출시한 이유는 무엇일까요? 사실 대규모 모델 운영, 품질 보증, 데이터 확보와 상업화 전략을 동시에 맞추는 일은 생각보다 까다로운 작업입니다.

우선 비용 구조와 경쟁 우위를 확보하는 문제가 핵심이에요. 또한 대규모 모델을 학습하고 배포하려면 API를 통한 안정적 연동과 프롬프트 설계가 필수적이며, 에이전트* 아키텍처로 여러 도구를 조합해 자동화된 워크플로우를 만들기도 합니다. 더 나아가 임베딩을 생성해 문서 간 의미 유사도를 계산하고 벡터 스토어에 저장해 빠른 검색을 가능하게 만드는 등 데이터 접근성과 검색 속도를 확보해야 합니다. 이와 함께 LLM 노드, Tool 노드, Guard 노드 같은 구성 요소로 시스템을 분리해 운영하고, 파일·벡터 스토어·웹 검색 기능을 연결해 문서 검색과 외부 지식 보강을 수행합니다.

비교해 보면 목적에 따라 선택지가 달라요. 예컨대 n8n은 약 500개 노드로 복잡한 자동화를 지원하는 반면 Agent Builder는 5개 노드로 빠르게 에이전트를 구성하도록 설계되어 있고, 퍼블리시 기능 → 체킷 연동 → UI 커스터마이징 과정을 통해 실제 서비스화할 수 있습니다. 또한 가드레일로 개인정보 유출 방지를 구현하고 휴먼 어프루벌로 민감 답변을 검토하며 MCP로 서드파티 앱 연동을 지원하는 점을 고려하면, 속도와 간편한 커스터마이징이 필요하면 Agent Builder 스타일을, 세밀한 자동화와 다양한 커넥터가 필요하면 n8n 스타일을 권장할 수 있어요. 마지막으로 실제 적용 목적(예: 고객 응대 챗봇 템플릿으로 환불/구독 해지 처리)에 따라 파일 벡터 스토어 연결, 프롬프트 튜닝, 휴먼 검토 등 우선 순위를 정해 투자 방향을 결정하는 것이 합리적이에요.

👤 MKTV 김미경TV • 👁️ 38,727회

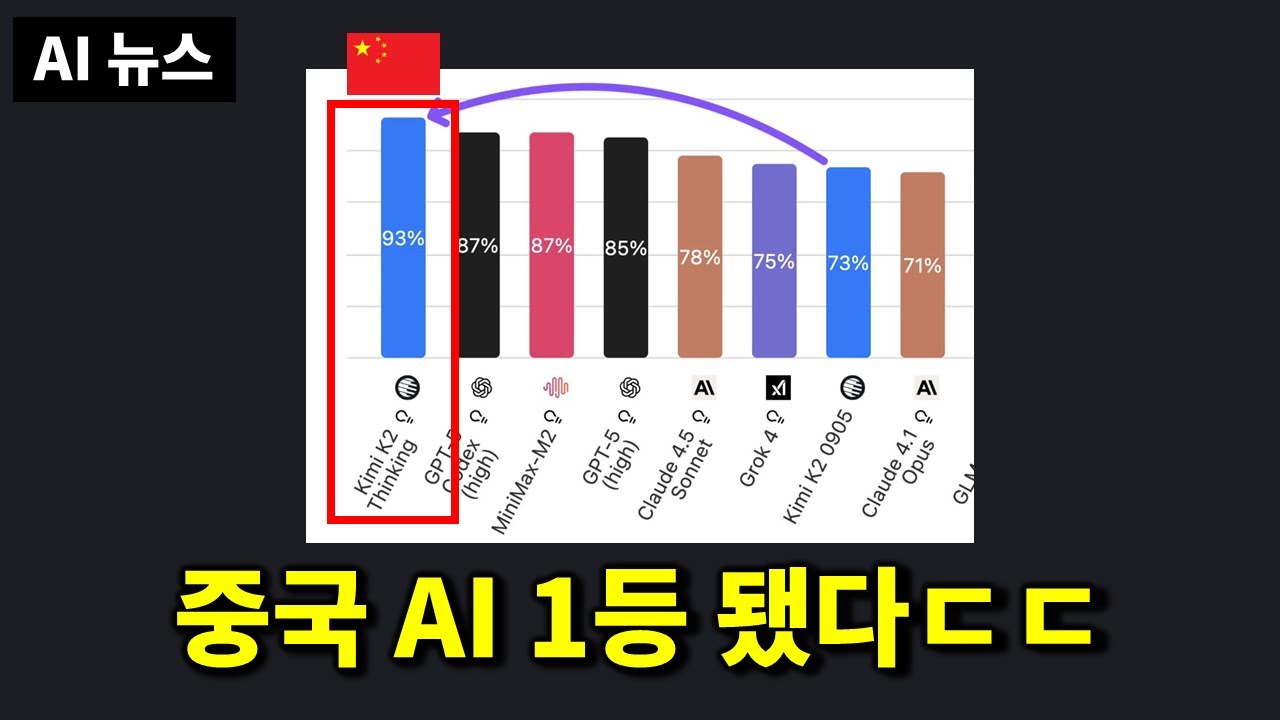

AI뉴스 - 중국 AI 전세계 1등 달성, 생각 읽는 AI, GPT 5.1, 애플 제미나이 탑재, Grok 업데이트, 나노바나나2 유출 등

AI뉴스 - 중국 AI 전세계 1등 달성, 생각 읽는 AI, GPT 5.1, 애플 제미나이 탑재, Grok 업데이트, 나노바나나2 유출 등

📋 3줄 요약

• 중국의 K2 AI 모델이 글로벌 대형 언어 모델 경쟁에서 성능과 비용의 균형을 통해 1등을 차지했어요.

• K2는 다양한 공개 벤치마크에서 뛰어난 성적을 냈고, 의료 이미지 분석에서도 유용한 진단 정보를 제공할 가능성을 보여주네요.

• 사용자는 성능, 프라이버시, 운영 편의성에 따라 오픈소스 K2 모델과 상용 Gemini/Grok 모델을 적절히 선정해 활용하는 것이 중요해요.

📖 자세한 내용 최근 문샷 AI에서 K2 싱킹 모델을 선보였어요. 중국발 대형 언어 모델 경쟁에 관심 있는 분이라면, '정말 중국 모델이 글로벌 1등을 차지한 걸까'라는 궁금증을 느끼실 텐데요. 문샷 AI가 K2를 공개한 이유는 성능과 비용을 동시에 잡아 글로벌 시장에서 영향력을 키우기 위함으로 보입니다. 사실 글로벌 벤치마크에서 상위권을 차지하는 일은 모델 규모, 하드웨어 자원, 데이터 품질과 같은 여러 요소를 균형있게 맞춰야 해서 생각보다 까다로운 작업입니다.

K2는 여러 공개 벤치마크에서 GPT-5나 Claude 4.5를 넘는 성적을 냈고, 특히 검색·에이전트* 활용·추론 영역에서 우수한 결과를 보이며 일부 기준에서는 1등을 기록했습니다. 더 나아가 종합 지표에서는 2등에 머무르는 항목도 있었는데, 이 과정에서 모델은 대략 1트릴리언 파라미터급의 설계와 MOE(전문화된 전문가 모델) 구조를 활용해 성능을 얻었고, 공개된 훈련 비용은 보도 기준으로 약 460만 달러(약 67억 원) 수준으로 알려졌습니다. 이런 구조는 집에서 돌리기엔 하드웨어와 클러스터 요구가 크지만, 오픈소스로 공개되면서 연구소나 기업들이 직접 활용해 도메인 특화 적용을 시도할 수 있게 되었습니다. 또한 K2가 의료 이미지(예: 엑스레이) 분석에서 비교적 자세하고 정확한 진단 정보를 제공한 사례가 보고되었고, 이 점은 실제 임상 보조 응용에서의 활용 가능성을 보여줍니다.

이와 함께 생태계 전반의 변화도 눈에 띕니다. 파이미우 PDF 프로 같은 파이썬 기반 문서 전처리 라이브러리는 이미지 기반 복잡문서의 레이아웃 분석기로 표·텍스트·좌표와 메타데이터를 정확히 추출해 판다스 데이터프레임으로 변환하고, 전화번호 등 민감정보를 정규식으로 탐지·삭제하는 기능까지 제공합니다. 또한 Gemini는 API를 통해 파일 도구와 내장 RAG(retrieval-augmented generation) 시스템을 제공해 랭체인 연결이나 벡터 스토어* 연계 없이도 문서 기반 대화를 쉽게 구성할 수 있게 되었고, 인베딩*을 무료로 제공하는 한도와 퍼리타임 인베딩·저장 정책을 통해 초기 비용 장벽을 낮추고 있습니다. Grok은 응답률과 리즈닝 개선(예: 응답률 77.5% → 94.1%, 리즈닝 77.9% → 97.9%) 같은 업데이트로 품질이 크게 향상됐고, Nanobanana2 같은 모델 유출 사례는 데스크탑/브라우저 환경에서 고해상도 이미지를 빠르게 생성하는 능력을 보여주며 개발자·연구자 커뮤니티의 관심을 끌었습니다. Anthropic 쪽에서는 MCP를 통해 워크플로우와 에이전트 실행을 최적화하려는 시도가 진행 중이며, 에이전트 설계 관점에서는 LLM 노드, Tool 노드, Guard 노드로 구성해 도구 호출과 안전성 검증을 분리하고 중간 결과로 컨텍스트를 잡아먹는 문제를 줄이는 접근을 시험하고 있습니다.

비교와 결론으로 말씀드리면, 성능 대비 비용 관점에서는 K2 같은 오픈소스 모델이 매우 매력적이며 내부 규제와 하드웨어를 감당할 수 있는 조직에는 경제적 대안이 됩니다. 반면 Apple이 Gemini를 Siri에 탑재하고 Apple의 클라우드에서 서빙하겠다는 보도처럼, 사용자 프라이버시와 운영 안정성을 우선하는 서비스는 Apple·Google 연계 모델을 선택하는 편이 낫습니다. 문서 자동화가 필요하다면 파이미우 PDF 프로로 이미지 혼합 문서에서 표와 텍스트를 추출해 파일을 벡터 스토어에 연결하여 문서 검색·요약·분류를 구현하고, 고객 응대 챗봇 템플릿으로 환불이나 구독 해지 처리 같은 반복 작업을 자동화하는 것을 추천드립니다. 더 나아가 에이전트·워크플로우 효율화를 원하시면 MCP로 서드파티 앱 연동을 구성하고, 체킷으로 위젯을 커스터마이징하여 퍼블리시 기능 → 체킷 연동 → UI 커스터마이징 흐름으로 배포하면 실무 적용이 수월합니다. 결국 선택은 비용·프라이버시·운영 편의성의 우선순위에 따라 달라지므로, 목표에 맞춰 오픈소스 K2 계열 또는 상용 Gemini/Grok 계열을 균형 있게 고려하시는 게 좋습니다.

👤 조코딩 JoCoding • 👁️ 27,013회

“AI는 버블이 아니라 ‘전환점’이다” 11월 핵심 투자 포인트 (박두환)

“AI는 버블이 아니라 ‘전환점’이다” 11월 핵심 투자 포인트 (박두환)

📋 3줄 요약

• AI는 산업의 전환점으로, 미국 정부의 대규모 AI 투자 전략이 이를 뒷받침하고 있어요.

• 미국은 AI 칩에서는 우위를 살리고 있지만, 데이터 센터와 전력 인프라에서는 중국과의 경쟁 구도가 계속될 것이라는 점이 중요해요.

• 장기적 메가트렌드에 맞춰 AI 관련 기업에 투자하고, 정치적 이벤트에 휘둘리지 말고 건강과 지속적인 소득을 유지하는 것이 전략적으로 바람직해요.

📖 자세한 내용 최근 미국 정부에서 AI 투자 전략을 선보였어요. AI 투자에 관심 있는 분이라면, 이것이 단순한 거품인지 아니면 산업의 전환점인지 궁금하실 텐데요. 미국 정부가 갑자기 AI 투자에 대대적으로 나선 이유는 무엇일까요? 사실 AI 경쟁에서 칩 확보, 데이터 센터와 전력 인프라 확보 등은 생각보다 까다로운 작업입니다. 미국은 AI 칩* 확보에서 우위를 점하고 있지만 데이터 센터와 안정적 전력 측면에서는 중국이 강점을 보이고 있어 두 국가 간 경쟁 구도가 단기간에 끝나지 않을 것이라는 배경이 형성되어 있어요.

또한 미국은 원전과 SMR을 중심으로 안정적인 전력 확보에 무게를 두고 있고 패스트랙 정책 같은 규제 완화와 재정 지원을 병행하며 데이터 센터* 확충에 자원을 쏟고 있어요. 이로 인해 반도체·데이터센터·에너지 관련 기업들이 실적·주가 측면에서 수혜를 보고 있는데 삼성전자와 SK하이닉스는 단기 상승을 보였고 두산과 두산에너빌리티는 작년에 거의 네 배에 가까운 주가 상승률을 기록했습니다. 시장은 중간중간 20~30%의 조정을 경험했지만 이런 이벤트가 발생할 때마다 정치적 이유나 뉴스가 매도 명분으로 활용되는 경향이 있으니, 단기적 노이즈에 휘둘리지 않는 것이 중요해요. 실행 관점에서는 매도·매수 판단을 정치 이벤트나 일시적 뉴스로만 하지 말고 개인의 건강과 지속적 소득을 유지하면서 장기적 메가트렌드를 따르는 전략이 현실적입니다.

더 나아가 비교해 보면 미국은 달러 발권력과 대규모 재정 투입 능력으로 기업들에 유리한 환경을 제공할 수 있는 반면 중국은 인프라·전력 측면에서 우위를 가지므로 어느 한쪽이 완전히 승리하기 전까지 경쟁은 장기화될 가능성이 큽니다. 그래서 추천 전략은 AI 칩*, 데이터 센터*, 전력 인프라*/SMR* 관련 공급망과 이를 뒷받침하는 인프라 기업들에 장기적으로 노출을 유지하는 것이고, 최소 10년 이상의 시계로 접근하는 것이 합리적이에요. 결국 단기 수익에 집착해 잦은 매매로 컨디션을 잃기보다는 자신의 건강과 소득을 지키며 성장하는 기업들과 동행하는 것이 장기적인 투자 성과에 더 유리하다는 점을 명확히 말씀드립니다.

👤 박두환의 실전투자교실 • 👁️ 21,550회

33 Google AI Features You Won't Believe are Free

33 Google AI Features You Won't Believe are Free

📋 3줄 요약

• Google AI에서 제공하는 다양한 무료 AI 기능은 Gemini, Veo 3.1, Nano Banana 등 생성 모델을 활용하여 사용자 맞춤형 워크플로우를 지원해요.

• Google AI Studio는 Vibe Code와 Stream Realtime을 통해 코드 스타일 조정과 실시간 인터랙션을 가능하게 하며, Gems는 반복 작업을 자동화하는 기능을 제공해요.

• Gmail, Sheets, Docs와 같은 일부 고급 AI 기능은 유료로 제공될 수 있으니, 이를 검토하는 것이 중요해요.

📖 자세한 내용 최근 Google에서 Google AI를 선보였어요. AI·기술·생산성 도구에 관심 있는 분이라면, 이 기능들이 정말 무료인지 궁금하실 텐데요. Google이 갑자기 이렇게 많은 AI 기능을 출시한 이유는 무엇일까요? 사실 기업 생태계 전반에 AI를 통합하고 사용자별로 달라지는 워크플로우*를 지원하는 일은 생각보다 까다로운 작업입니다.

Google은 Gemini, Veo 3.1, Nano Banana, Imagen 같은 생성 모델과 Google AI Studio를 축으로 다양한 기능을 풀어놨어요. 또한 Google AI Studio 안에서는 Vibe Code로 코드 스타일과 출력 톤을 조정하고 Stream Realtime으로 실시간 인터랙션을 구성할 수 있어요. Gems는 반복 작업을 자동화하는 '미니 자동화'로, Canvas와 Opal은 간단한 미니 앱·위젯을 만드는 환경을 제공하며 퍼블리시 기능을 통해 체킷으로 위젯 커스터마이징이 가능해요. 더 나아가 Video understanding 기능과 Voice Mode with Vision은 영상·음성 기반의 문맥 추출을 돕고, NotebookLM은 문서 기반 심층 리서치와 문서 검색을 지원합니다. Make AI Agents 기능을 활용하면 에이전트를 설계해 특정 업무를 대행하게 할 수 있는데, 에이전트는 LLM 노드, Tool 노드, Guard 노드로 구성되어 있어요. 예를 들어 파일을 벡터 스토어에 연결하여 문서 검색 결과를 바탕으로 응답하고, 웹 검색 기능을 결합해 최신 정보를 보강하는 워크플로우를 짤 수 있어요. 또한 가드레일로 개인정보 유출을 방지하고 휴먼 어프루벌로 답변을 검토하는 방식으로 안전성을 확보할 수 있습니다.

데이터 분석과 생성 워크플로우 측면에서는 Gemini의 Data Analysis, NotebookLM과 임베딩을 활용한 검색, RAG 기반으로 문맥을 보강하는 조합이 유용해요. 이미지·비디오 파이프라인은 Flow for Veo, Imagen, Nano Banana처럼 각 모델을 연결해 제작과 편집을 자동화하고, Stream Realtime은 실시간 피드백 루프를 만들어 인터랙티브한 앱을 가능하게 합니다. 통합 관점에서 보면 n8n은 500개 노드로 광범위한 서드파티 연결을 제공하는 반면, Google의 미니 앱·에이전트 도구는 소규모 템플릿과 통합 중심으로 빠른 프로토타이핑에 최적화되어 있어요(Agent Builder는 LLM/Tool/Guard 구조로 설계되어 기본 구성 요소가 적은 편이에요). 따라서 빠르게 프로토타입을 만들고 UI 위젯으로 배포하려면 Gems와 Canvas, 체킷 연동 흐름이 적합하고, 문서 중심의 자동화·지식 응답 시스템을 만들려면 벡터 스토어와 NotebookLM 기반의 RAG 결합을 추천해요. 단, Gmail, Sheets, Docs 등 일부 고급 AI 기능은 유료로 제공되는 경우가 있으니 비용 부분은 반드시 검토하셔야 해요.

👤 Futurepedia • 👁️ 20,763회

n8n JUST Leveled Up AI Agents With Guardrails: Here's How It Works

n8n JUST Leveled Up AI Agents With Guardrails: Here's How It Works

📋 3줄 요약

• n8n의 Guardrails node는 AI 자동화에서 위험 요소를 사전에 탐지하고 처리할 수 있는 새로운 기능이에요.

• 이 노드는 키워드 필터링, 복합 규칙 등을 통해 개인식별정보(PII) 및 악성 URL 등을 차단할 수 있도록 설계되었어요.

• Guardrails node를 활용하면 안전한 AI 워크플로우를 신속하게 구축하고, API 연동과 프롬프트 엔지니어링을 통해 운영 체계를 강화할 수 있어요.

📖 자세한 내용 최근 n8n에서 Guardrails node를 선보였어요. AI 자동화와 에이전트* 안전성에 관심 있는 분이라면, 이 기능으로 어떤 위험을 사전에 차단할 수 있을지 궁금하실 텐데요. n8n이 갑자기 Guardrails node를 출시한 이유는 무엇일까요? 사실 AI 워크플로우에서 개인식별정보(PII), 비밀 키, 악성 URL, 혹은 탈옥(jailbreak) 시도 같은 위험을 모델에 전달되기 전에 탐지하고 자동으로 처리하는 일은 생각보다 까다로운 작업입니다.

Guardrails node는 구체적으로 키워드 기반 필터링부터 복합 규칙까지 다양한 검사 규칙을 제공해요. 또한 LLM 노드, Tool 노드, Guard 노드 같은 구성 요소와 함께 동작하며, Keywords(키워드), Jailbreak, Not Safe For Work(NSFW), Personal Data(PII), Secret Keys, Topical Alignment, URLs, Custom / Guardrail Stacking 같은 여러 유형의 가드레일을 지원합니다. 더 나아가 파일, 벡터 스토어* 연결을 통해 문서 검색 결과를 사전 검사하거나 웹 검색 결과의 URL을 검사해 위험을 차단할 수 있고, 프롬프트*를 전달하기 전 프리프로세싱으로 텍스트를 정제하거나 레드액션/차단/태깅 등 다양한 후속 조치를 실행할 수 있어요. 퍼블리시 기능 → 체킷 연동 → UI 커스터마이징 과정으로 에이전트를 퍼블리시하고, MCP로 서드파티 앱 연동하거나 체킷으로 위젯을 커스터마이징하는 흐름이 자연스럽게 연결됩니다.

실제 사용 사례로는 파일 벡터 스토어에 연결하여 문서 검색 결과에서 PII를 감지해 자동으로 마스킹하거나, 고객 응대 챗봇 템플릿으로 환불/구독 해지 처리 시 비밀 키가 노출되지 않도록 차단하는 방식이 있어요. 또한 가드레일 스태킹을 통해 여러 규칙을 조합하고 휴먼 어프루벌로 민감한 응답을 검토하도록 설정하거나, AI 없이도 텍스트를 정제하는 Sanitizing Text Without AI 옵션을 활용할 수 있습니다. 비교하자면 n8n은 500개 노드, Agent Builder는 5개 노드 같은 생태계 규모 차이를 보이며, 코드 없이 빠르게 안전한 워크플로우를 구성하려면 Guardrails node가 실무에서 유용하고, RAG 시스템**과 연계해 외부 지식 검색 결과의 품질과 안전성을 동시에 확보할 때 특히 가치가 큽니다. 결론적으로 신속하게 안전장치를 갖춘 AI 자동화를 구축하려면 Guardrails node를 핵심으로 구성하고, API 연동과 프롬프트 엔지니어링을 병행해 운영·감시 체계를 마련하는 것을 권합니다.

👤 Nate Herk | AI Automation • 👁️ 16,585회

I Stopped Using AI To Code For 30 Days

I Stopped Using AI To Code For 30 Days

📋 3줄 요약

• AI 없이 30일 동안 코딩을 하면서 실력을 유지하고 향상시키는 방법에 대한 실험 결과를 보여줘요.

• 이 실험에서 AI 의존성을 줄이기 위해 코딩 로직을 직접 작성한 후 AI를 보조적으로 활용하는 방식을 권장해요.

• AI는 유용한 도구이지만, 최종 결정은 인간이 내려야 하며, 문서 읽기와 직접 코딩을 통해 실력을 쌓는 것이 중요하다고 강조해요.

📖 자세한 내용 최근 Syntax에서 AI 코딩 중단 실험을 선보였어요. AI로 코딩하는 방식 변화에 관심 있는 분이라면, 30일 동안 AI 없이 코딩하면 어떤 변화가 생기는지 궁금하실 텐데요. Syntax가 갑자기 AI 코딩 중단 실험을 시작한 이유는 무엇일까요? 사실 AI에 의존하면서 코딩 실력과 검색 능력이 점차 약해지는 문제는 생각보다 까다로운 작업입니다. 진행자 CJ는 30일 동안 GraphQL API*를 리버스 엔지니어링하는 작업부터 CLI 이미지 다운로드 스크립트, 실시간 문법 오류 찾기 게임, 오래된 기기에 Linux 설치하기 등 다양한 프로젝트를 직접 수행하면서 AI 금단 현상과 학습 효과를 체험했습니다.

먼저 실전적 권장 방법은 핵심 로직과 예제 코드를 먼저 직접 작성한 뒤에 AI를 보조적으로 활용하는 방식이에요. 또한 사진 촬영 같은 비코딩 창작 활동으로 즐거움을 분산시키면 코딩 의욕을 유지하는 데 도움이 되고, Stack Overflow에서 무심코 코드를 복사해 오는 습관은 불편함을 유발하니 문서를 읽는 연습을 늘려야 한다고 강조했습니다. 더 나아가 초기 기술 검증이나 빠른 실험은 AI 에이전트를 통해 여러 선택지를 검토하는 데 유용하지만, 최종 기술 결정은 사람이 내려야 하고 에이전트가 제시한 결과를 비교·검증하는 과정이 필요하다고 말합니다. 프롬프트에만 의존하면 문제 해결의 깊이를 놓치기 쉬우니 프롬프트를 다듬기 전에 설계와 디버깅을 스스로 해보라는 조언도 포함되어 있어요.

검색 환경 변화 측면에서는 AI 기반 검색이 AI가 생성한 기사들을 근거로 답하는 비중을 늘리면서 전통적 웹 검색과 Stack Overflow의 역할이 약화되고, 오히려 프리-AI 인터넷 자료들이 가치 있게 재평가될 것이라고 진단합니다. 따라서 실무적 권고는 초기 아이디어·스파이크는 AI로 빠르게 탐색하되 실제 구현, 디버깅, 기술 선택과 같은 핵심 학습 경험은 직접 수행하며 문서 읽기와 실전으로 실력을 쌓는 것이고, 창의적 활동을 병행해 번아웃과 의존성을 줄이는 것입니다. 결론적으로 AI는 강력한 도구지만 인간이 의사결정자 역할을 유지하면서 에이전트를 보조적으로 활용하는 방식이 장기적으로 기술 역량과 판단력을 지키는 데 가장 효과적이라는 점을 제시합니다.

👤 Syntax • 👁️ 14,933회

Prompt Engineering for LLMs, PDL, & LangChain in Action

Prompt Engineering for LLMs, PDL, & LangChain in Action

📋 3줄 요약

• LangChain의 PDL은 대형 언어 모델과의 상호작용을 코드화하여, 더 안정적이고 재현 가능한 프롬프트 설계를 가능하게 해요.

• PDL은 입력과 제어 흐름을 구조화하여 프롬프트 기반 로직을 코드처럼 다루게 하고, 다양한 노드를 통합하여 복잡한 도구 연동을 자동화해요.

• PDL과 LangChain을 활용하면 개인정보 보호 및 민감한 데이터 검토가 가능해져 실제 업무에 쉽게 적용할 수 있는 프로세스를 구축할 수 있어요.

📖 자세한 내용 최근 LangChain에서 PDL을 선보였어요. *프롬프트 엔지니어링**과 LLM 통합에 관심 있는 분이라면, 어떻게 더 안정적이고 재현 가능한 프롬프트를 설계하고 복잡한 도구 연동을 자동화할 수 있을지 궁금하실 텐데요. LangChain이 갑자기 PDL을 출시한 이유는 무엇일까요? 사실 대형언어모델과의 상호작용을 코드화하고, 도구 호출을 안전하게 관리하며, 동일한 동작을 반복 가능하게 만드는 작업은 생각보다 까다로운 작업입니다.

PDL은 더 구조화된 입력과 제어 흐름을 통해 프롬프트 기반 로직을 코드처럼 다룰 수 있게 설계되어 있어요. 또한 LangChain은 에이전트 패러다임**을 통해 LLM에 단일 지시만 주는 대신 여러 단계의 워크플로우를 구성할 수 있게 하고, 이 과정에서 LLM 노드, Tool 노드, Guard 노드 같은 구성 요소로 역할을 분리합니다. 더 나아가 API* 연동을 손쉽게 처리해 외부 서비스 호출을 자동화하고, 임베딩을 생성해 벡터 검색을 수행하면서 벡터 스토어에 연결해 파일 기반 문서 검색과 RAG(검색 기반 생성) 흐름을 구성할 수 있어요. 또한 PDL/Agent 조합은 가드레일을 통해 개인정보 유출을 차단하고, 휴먼 어프루벌로 민감한 답변을 검토하도록 설계할 수 있습니다.

비교하자면 저코드 자동화 플랫폼과 달리 LangChain의 에이전트 접근법은 노드 수는 적지만 구성 요소를 명확히 분리합니다; n8n은 500개 노드, Agent Builder는 5개 노드라는 비교 수치처럼 범용 노드 축적 대신 핵심 노드로 단순화된 구성이 장점이에요. 예를 들어 고객 응대 챗봇 템플릿을 만들 때는 파일, 벡터 스토어에 연결하여 문서 검색으로 근거를 제공하고, 도구 노드를 통해 환불/구독 해지 처리를 자동화하며, 퍼블리시 기능 → 체킷 연동 → UI 커스터마이징 순으로 배포하면 실무에 바로 적용할 수 있습니다. 이와 함께 MCP로 서드파티 앱 연동하고 체킷으로 위젯을 커스터마이징하면 내부 시스템에 맞춘 인터랙션을 구축하기 좋으니, 재현성 높은 프롬프트와 복잡한 도구 오케스트레이션이 필요하다면 PDL과 LangChain 조합을 우선 고려해 보세요.

👤 IBM Technology • 👁️ 13,315회

The AI Agent That Will Replace Your Entire Workflow by 2026

The AI Agent That Will Replace Your Entire Workflow by 2026

📋 3줄 요약

• Abacus의 deep agent는 업무의 완전 자동화를 가능하게 하며, 다양한 복잡한 작업을 자율적으로 수행할 수 있어요.

• 이 AI 에이전트는 리드 생성 자동화, 구직 자동화 및 콘텐츠 큐레이션 등 여러 업무를 철저하게 처리하며, 외부 서비스와의 API 연동을 통해 더 강력한 기능을 제공해요.

• 기업은 저위험의 반복 업무부터 시작해 AI 에이전트를 도입하며, 조직의 역량을 키우고 예비 파일럿을 통해 안전하게 적용해 나가는 것이 중요해요.

📖 자세한 내용 최근 Abacus에서 deep agent를 선보였어요. AI 에이전트*에 관심 있는 분이라면, 어떤 업무가 완전 자동화되고 회사 조직은 어떻게 준비해야 할지 궁금하실 텐데요. Abacus가 갑자기 deep agent를 출시한 이유는 무엇일까요? 사실 여러 단계로 구성된 업무를 완전 자율적으로 실행하고 리스크를 관리하는 것은 생각보다 까다로운 작업입니다. 또한 기술 발전 속도가 너무 빨라 몇 달 사이에 업무 양상이 급격히 변할 가능성이 큽니다.

Abacus deep agent의 핵심은 실제 실행력에 있어요. 먼저 아키텍처 관점에서 Agent는 LLM 노드, Tool 노드, Guard 노드로 구성되어 있고, 또한 API* 연동을 통해 외부 서비스와 통신하며 더 나아가 퍼블리시 기능 → 체킷 연동 → UI 커스터마이징 같은 흐름으로 배포할 수 있어요. 예시로 리드 생성 자동화(lead generation autopilot)는 agent가 LinkedIn을 브라우징하여 이상적 후보를 식별하고 연락처 정보를 추출해 리스트를 만드는 식으로 작동하며 이 모든 과정을 사람이 자는 동안에도 수행할 수 있어요. 또한 구직 자동화에서는 채용 공고를 읽고 프롬프트에 기반해 지원서를 맞춤 작성하고 양식을 제출한 뒤 응답을 추적하는 수준까지 가능합니다. 콘텐츠 측면에서는 YouTube 채널을 분석해 패턴을 추출하고 큐레이션된 재생목록을 만드는 등 스크래핑과 이해(comprehension)를 결합하며, 파일, 벡터 스토어, 웹 검색 기능을 연동해 파일 벡터 스토어에 연결하여 문서 검색과 임베딩* 기반 유사도 검색을 수행하고 RAG* 방식으로 응답을 보강할 수 있어요. 더 나아가 반복적 업무 제거는 데이터 입력, 리서치 컴파일, 리포트 생성, 이메일 관리 같은 작업에 적용되고, 가드레일로 개인정보 유출 방지 및 휴먼 어프루벌로 답변 검토를 두어 위험 관리를 병행합니다. 비교 수치도 참고할 만한데, n8n은 500개 노드, Agent Builder는 5개 노드 같은 설계 철학의 차이가 존재하고 고객 응대 챗봇 템플릿으로 환불/구독 해지 처리 같은 구체적 템플릿을 제공해 바로 활용할 수 있어요. 마지막으로 Abacus가 말하는 발전 패턴은 스케일링 법칙(컴퓨트 예측 → 성능 점프), 추론(think longer)으로 인한 능력 증가, 그리고 증류(distillation)를 통한 세대 간 학습 가속의 세 가지 축으로 요약됩니다.

비교와 결론으로, 이번 변화는 과거 기술혁명과 달리 몇 달 단위로 벌어질 수 있어요. Fortune 500 기업들은 이미 hybrid workforces를 도입해 매니저들이 사람과 에이전트의 복합 팀을 감독하는 방향으로 이동할 가능성이 크고, 핵심은 어떤 업무에 자율성을 부여할지(리스크·복잡성 기준)를 결정하는 것입니다. 따라서 권장되는 접근법은 먼저 규칙 기반·반복적이고 저위험 업무를 자동화해 성과를 검증하고, 민감하거나 고위험 작업에는 휴먼 감독을 유지하며 점진적으로 수준을 높이는 것입니다. 또한 조직은 API 연동 능력, 프롬프트 설계 역량, 임베딩과 벡터 스토어를 이해하는 방향으로 역량을 쌓고 내부적으로 작은 파일럿을 빠르게 돌려 경험을 축적하는 편이 안전하면서도 실질적인 대비가 됩니다.

👤 Julia McCoy • 👁️ 13,162회

카카오톡 새 업데이트! 불편한 기능은 사라지고, AI 챗GPT가 새로 들어왔습니다

카카오톡 새 업데이트! 불편한 기능은 사라지고, AI 챗GPT가 새로 들어왔습니다

📋 3줄 요약

• 카카오톡 V25.9.1 업데이트를 통해 사진 확대 시의 실수로 좋아요가 눌리는 불편함과 메시지 삭제 시간이 5분에서 24시간으로 늘어났어요.

• 새롭게 통합된 AI 기능인 GPT는 별도의 앱 설치 없이 카카오 계정으로 로그인해 음성 입력도 지원하며, 생활에서 유용한 정보 제공이 가능해졌답니다.

• 통화녹음은 최대 30분까지 지원되며, AI가 자동으로 대화별 텍스트와 요약을 제공해 통화 내용을 편리하게 관리할 수 있어요.

📖 자세한 내용 최근 카카오에서 카카오톡 V25.9.1을 선보였어요. 카카오톡 업데이트와 AI 통합에 관심 있는 분이라면, 어떤 불편한 기능이 사라지고 어떤 새 기능이 추가됐는지 궁금하실 텐데요. 카카오가 갑자기 카카오톡 V25.9.1을 출시한 이유는 무엇일까요? 사실 사진을 확대하다가 실수로 좋아요가 눌리는 문제나 통화 내용을 유용하게 정리하는 일은 생각보다 까다로운 작업입니다.

특히 이번 업데이트에서는 사용성 개선과 AI 기능이 함께 들어왔어요. 먼저 프로필 사진이나 게시물에서 사진을 확대할 때 자동으로 하트가 눌리던 동작이 제거되어 이제는 옆의 좋아요 아이콘을 직접 눌러야만 반응이 표시되도록 바뀌었고, 기존의 친구 목록 피드에서 사진과 글이 섞여 찾기 불편했던 부분도 좀 더 안정적으로 다뤄졌습니다. 또한 메시지 삭제 관련 방식이 바뀌어 예전에는 보낸 뒤 5분 이내만 삭제 가능했지만 이제는 24시간까지 삭제할 수 있고 피드형 표시에서는 누가 삭제했는지 보이지 않게 되어 대화 부담을 줄였습니다. 새롭게 통합된 GPT* 기능은 별도 앱 설치 없이 채팅 화면 상단의 GPT 탭을 통해 카카오 계정으로 바로 로그인하거나 기존 유료 구독 계정과 연결해 쓸 수 있고, 텍스트 입력뿐 아니라 왼쪽 아래 마이크로 음성으로 물어볼 수 있는 음성 입력도 지원합니다. 생활에서의 활용도 예시는 약 이름이나 약 복용 궁금증을 간단히 물어보거나 축하·인사 문장 생성, 여행지 추천과 1박 일정표 생성처럼 일상 문의를 한두 번의 질의로 해결하는 방식입니다. 더 나아가 보이스톡에서는 통화 중 화면 공유가 가능해 스마트폰 화면을 실시간으로 보여주며 설명할 수 있고, 통화녹음* 기능은 통화 연결 후 녹음을 누르면 최대 30분까지 녹음·일시정지·저장이 가능하며 녹음된 파일을 AI가 분석해 대화별 텍스트와 AI 요약*을 자동으로 만들어 통화탭에서 녹음본과 요약을 바로 확인할 수 있습니다. 다만 화면 공유 시 문자나 계좌 등 민감 정보는 미리 닫아두는 등 주의가 필요하고, GPT가 제공하는 건강·의료 정보는 참고용으로 실제 진료는 전문가 확인이 필요하다는 안내가 붙습니다.

종합하면 이번 업데이트는 작은 사용성 개선과 함께 실용적인 AI 기능이 결합된 변화입니다. 수치로 보면 메시지 삭제 시간이 기존의 5분에서 24시간으로 늘어났고, 통화녹음은 최대 30분까지 지원되는 점이 눈에 띕니다. 개인적으로는 사진 확대 시 실수로 좋아요가 눌리던 불편을 겪으셨던 분과 통화 내용을 기록·요약해 업무나 가족 대화 관리를 편하게 하고 싶은 분께 업데이트를 권합니다. 다만 GPT로 얻은 의학적·법률적 조언은 반드시 전문가 확인을 병행하고, 통화녹음과 화면 공유는 개인정보 노출에 유의해 제한된 상황에서만 활용하시는 것이 좋습니다.

👤 똑순이 은쌤 • 👁️ 12,112회

The Truth About Starting Web Design In The Age Of AI

The Truth About Starting Web Design In The Age Of AI

📋 3줄 요약

• AI의 등장이 웹 디자이너의 시작과 커리어에 미치는 영향은 단순히 도구의 변화에 그치지 않아요.

• Flux Academy는 웹 디자인을 처음 배우는 이들을 위해 40% 할인과 무료 교육 프로그램을 제공하고 있어요.

• 이러한 자원을 활용해 변화의 본질을 이해하고, 실질적인 학습 경로를 고민하는 것이 중요해요.

📖 자세한 내용 최근 Flux Academy에서 The Truth About Starting Web Design In The Age Of AI를 선보였어요. 웹 디자인과 AI에 관심 있는 분이라면, 'AI가 웹 디자이너의 시작과 커리어에 어떤 영향을 줄까'에 대해 궁금하실 텐데요. Flux Academy가 갑자기 The Truth About Starting Web Design In The Age Of AI를 공개한 이유는 무엇일까요? 사실 웹 디자인으로 수익을 내고 지속적으로 클라이언트를 확보하는 일은 생각보다 까다로운 작업입니다.

영상 설명에는 웹 디자인을 처음 시작하려는 사람들을 위해 실질적 자원과 제안이 소개되어 있어요. 특히 Flux Academy가 Black Friday 세일로 모든 코스에 대해 40**% 할인과 4개월 추가 멘토링**을 제공한다고 안내하고, 무료 교육인 "3 Steps to Build a Thriving Web Design Career"도 함께 제공한다고 명시되어 있어요. 또한 Ran Segall의 Instagram과 X, Flux Academy의 Instagram과 TikTok 계정이 목록으로 제시되어 있어 관심 있는 분들이 참고할 수 있게 되어 있어요. 이러한 안내는 학습 경로와 멘토링 옵션을 고민하는 사람들에게 구체적 선택지를 제시해 줘요.

정리하자면, 이 콘텐츠는 단순히 AI 도구의 등장이 아니라 웹 디자이너로서의 진입과 성장에 영향을 미치는 더 넓은 변화에 주목하라고 말하고 있어요. 그러므로 AI 자체만을 이유로 시작을 미루기보다는 변화의 본질을 이해하고, 학습 경로와 멘토링, 실무 중심의 훈련과 같은 구체적 자원을 검토해 보시는 것을 권해요. Flux Academy가 제시한 할인과 무료 교육 링크는 그런 선택을 검토하는 데 참고가 되는 정보로 보시면 돼요.

👤 Flux Academy • 👁️ 11,506회

AI Is About To Break Reality! (30 Things You’re Not Ready For)

AI Is About To Break Reality! (30 Things You’re Not Ready For)

📋 3줄 요약

• AI와 로봇, 특히 Figure 3이 인간의 감정, 법, 경제에 깊숙이 개입하면서 사회적 갈등과 착취 가능성을 일으키고 있어요.

• 데이팅 분야에서는 AI agents가 사용자 대신 활동하며 경제적 착취와 정서적 의존의 위험이 증가하고 있으며, 로봇 자동화는 법적 지위에 대한 논쟁을 불러오고 있어요.

• 기업과 정부는 AI의 책임 있는 사용을 위해 명확한 과금 정책과 규제 틀을 마련해야 하며, 개인은 비판적 판단과 디지털 리터러시를 강화해야 해요.

📖 자세한 내용 최근 Figure에서 Figure 3 로봇을 선보였어요. AI의 급격한 변화에 관심 있는 분이라면, 앞으로 어떤 현실 변화가 닥칠지 궁금증을 느끼실 텐데요. Figure가 갑자기 Figure 3을 출시한 이유는 무엇일까요? 사실 로봇과 AI가 인간의 감정·법·경제에 깊숙이 개입하는 일은 생각보다 까다로운 작업입니다. 이 영상은 데이트, 로봇, 정치, 경제, 종교까지 AI가 어떻게 파고들고 있는지를 연속적인 사례로 보여줘요. 또한 단순한 기술 발전을 넘어 사회적·법적 갈등과 착취 가능성까지 함께 제기하고 있어요.

특히 현실에서 이미 실행되는 구체적 사례들을 보면 더 위험과 기회가 명확해집니다. 먼저 데이팅 영역에서는 개인 대신 행동하는 agents가 등장해 사용자의 대화나 데이트를 대신하거나 다른 사람의 AI와 상호작용해 호환성 리포트를 내주고, Replica, Anima, Kindroid 같은 회사들이 실제 관계를 시뮬레이션하는 서비스로 성장하고 있음을 보여줘요. 또한 일부 동반 AI들은 micropayments를 요구하며 음란물 생성이나 추가 서비스를 과금 형태로 제공하는데, 이것이 자본주의와 결합해 성적 착취로 이어질 수 있다는 경고도 나옵니다. 로보틱스 측면에서는 Figure 3이 빨래를 개거나 키카드를 전달하는 등 민첩한 작업을 수행했고, 이런 물리적 능력 때문에 로봇 동반자와의 법적·감정적 연결(혼인 요구 등)에 대한 논쟁이 커지고 있어요. 더 나아가 ChatGPT의 GPT5 업데이트처럼 일부 모델은 성격을 제거하거나 변화시키며 사용자와의 감정적 연결이 변동하는 사례가 나오고, 정부와 기관들은 LLM을 정책결정이나 외교에 활용하는 움직임을 보이며 Albania의 정부 직책 생성, Swedish prime minister의 ChatGPT 활용 사례 등이 소개됩니다. 이와 함께 desensorizing 운동과 uncensored versions*를 로컬에서 돌리는 흐름은 누구나 필터 없는 모델을 내려받아 불법적이거나 금지된 지시를 받을 수 있게 해 현실 통제가 어렵다는 문제를 드러냅니다. 영상은 Replica의 1.2백만 사용자 수, 일부 직무의 시급이 $50 미만으로 하락한 사례, Schlommo가 6개월 만에 플랫폼을 Wix에 $80M에 매각한 사례 등 구체적 수치로 산업 변화의 속도와 규모를 제시해요.

결론적으로 다양한 영역에서 AI가 인간 삶을 재편하고 있으며, 비교하면 데이트·감정 영역과 물리적 로봇 영역은 다른 종류의 위험과 혜택을 동반합니다. 데이트·동반자 AI는 정서적 의존과 경제적 착취 위험이 크고, 로봇·물리적 자동화는 법적 지위와 노동 시장 충격을 더 크게 만듭니다. 따라서 명확한 추천은 다음과 같습니다: 기업은 연령 검증과 투명한 과금 정책을 의무화하고 모델의 ‘무검열 버전’ 제공 시 책임 분담과 접근 통제를 마련해야 하며, 정부와 규제 기관은 연령·윤리·사기 방지를 위한 법적 틀과 피해 구제 절차를 신속히 정비해야 해요. 또한 개인과 조직은 AI 출력에 대해 비판적 판단을 유지하고 디지털 리터러시를 강화해 감정적·경제적 착취에 취약해지지 않도록 대비하는 것이 필요합니다.

👤 AI Samson • 👁️ 11,345회

The World's BEST New AI Model is 100% Free (Kimi K2 Thinking)

The World's BEST New AI Model is 100% Free (Kimi K2 Thinking)

📋 3줄 요약

• Kimi에서 출시한 K2 Thinking은 성능이 좋으면서도 100% 무료로 제공되는 새로운 AI 모델이에요.

• 현재로서는 K2 Thinking의 구체적인 기능과 성능 지표에 대한 정보가 부족해요.

• 추가 자료가 확보되면 K2 Thinking을 다른 모델들과 비교하고 실무 도입에 대한 보다 구체적인 추천을 드릴 수 있어요.

📖 자세한 내용 최근 Kimi에서 K2 Thinking을 선보였어요. 무료로 공개된 새로운 AI 모델 소식에 관심 있는 분이라면, '정말 성능이 좋으면서도 100**% 무료일까**'라는 궁금증을 느끼실 텐데요. Kimi이 갑자기 K2 Thinking을 출시한 이유는 무엇일까요? 사실 고성능 모델을 비용 없이 배포하면서도 접근성, 성능, 개인정보 보호를 동시에 만족시키는 일은 생각보다 까다로운 작업입니다.

제공된 자막 데이터는 재생 목록 정보와 자막 파일 URL만 포함되어 있어서 모델의 구체적 기능, 성능 지표, 데모나 사용법 등 기술 설명은 확인할 수 없어요. 또한 프롬프트* 설계 방식이나 온디바이스 추론* 지원 여부, 서비스화 과정에서의 PII* 보호 대책처럼 초보자가 알고 싶어하는 핵심 구현 세부사항도 확인할 수 없는 상태예요. 따라서 모델의 아키텍처, 학습 데이터, 파인튜닝* 가능성, 응답 지연이나 토큰* 비용 같은 항목에 대한 명확한 정보가 제공되지 않았습니다.

비교와 결론으로는, 현재 제공된 메타데이터만으로는 K2 Thinking을 다른 공개 모델들과 수치로 비교하거나 특정 용도에 추천하기 어렵습니다. 명확한 비교와 실무 도입 판단을 위해서는 공식 릴리스 노트, 기술 문서나 논문, 데모 영상의 전체 자막과 배포·API* 정보가 필요해요. 이러한 추가 자료가 확보되면 기능별(예: 온디바이스 추론 지원 여부, 프롬프트 최적화 방법, 개인정보 가드레일)로 실무적 추천을 드릴 수 있습니다.

👤 Limitless Podcast • 👁️ 11,065회

How to Actually Use n8n's AI Builder to Get Results

How to Actually Use n8n's AI Builder to Get Results

📋 3줄 요약

• n8n의 AI Builder는 복잡한 워크플로 자동화와 예측 가능한 결과 생성을 위한 도구로 활용될 수 있어요.

• LLM 노드, Tool 노드, Guard 노드 등의 핵심 블록으로 구성되어 있으며, 변수 흐름과 리스크 관리가 필수적이에요.

• 작은 워크플로부터 시작해 반복적으로 다듬어가며 안정성을 확보하는 접근이 가장 실용적이에요.

📖 자세한 내용 최근 n8n에서 AI Builder를 선보였어요. AI Builder 사용법에 관심 있는 분이라면, 어떻게 실제로 결과를 내는 워크플로를 만들 수 있는지 궁금하실 텐데요. n8n이 갑자기 AI Builder를 출시한 이유는 무엇일까요? 사실 AI로 워크플로를 자동화하고 노드 간 변수 전달과 출력 품질을 안정화하는 작업은 생각보다 까다로운 작업입니다. 특히 API* 연동, 프롬프트* 설계, 노드 구성과 변수 흐름 관리가 실무에서 자주 걸림돌로 작용해요. 따라서 단순한 자동화가 아니라 예측 가능한 결과를 얻기 위한 설계가 필요합니다.

AI Builder의 구성은 LLM 노드, Tool 노드, Guard 노드 같은 핵심 블록으로 이루어져 있어요. 특히 LLM 노드가 외부 검색 서비스(예: Perplexity, Tavly)나 웹 검색 API와 연동해 자료를 수집하고, Tool 노드가 그 결과를 가공·변환하며, Guard 노드가 개인정보 유출 같은 리스크를 차단하는 흐름을 만듭니다. 또한 에이전트* 기능을 이용해 여러 에이전트가 주제별로 역할을 나눠 협업하도록 구성할 수 있고, 병렬 브랜치를 이용해 여러 검색을 동시에 수행한 뒤 Merge 노드에서 합치는 패턴도 확인할 수 있어요. 실제 사용 예로는 매일 오전에 실행되는 스케줄 트리거로 Perplexity에서 최신 업계 동향을 조회하고, 레시피 하나와 동기부여 문구를 추출해 이메일로 전송하는 워크플로를 만들 수 있습니다. 이 과정에서 변수 매핑이나 필드 이름에 공백·특수문자·언더스코어가 포함되면 값이 null로 나오거나 표현식 접근이 깨지는 문제가 자주 발생하므로 초기에 꼼꼼히 파라미터*와 변수 흐름을 설계해야 합니다.

비교하면 AI Builder는 단발성 자동화가 아니라 LLM 기반 입출력과 외부 검색을 조합해 실무용 결과물을 만드는 도구로, 복잡한 멀티에이전트 시나리오나 병렬 검색 병합에서 예상치 못한 동작이 발생할 수 있습니다. 따라서 권장되는 접근은 작은, 예측 가능한 워크플로부터 시작해 반복적으로 프롬프트와 노드 구성을 다듬고 Guard 노드로 안전장치를 마련하는 것입니다. 또한 클라우드 플랜의 크레딧 한도나 외부 API 호출 비용을 고려해 단계적으로 확장하는 것이 좋습니다. 결론적으로 빠르게 시도해 볼 수 있는 기반이면서도 실제 운영 수준의 안정성을 얻으려면 반복 테스트와 변수 관리, 그리고 필요한 경우 human-in-the-loop 검토를 병행하는 방식이 가장 실용적이에요.

👤 Nate Herk | AI Automation • 👁️ 9,691회

AI Coding Finally Fixed, New AI Models, Huge Gemini Deal and More!

AI Coding Finally Fixed, New AI Models, Huge Gemini Deal and More!

📋 3줄 요약

• GitHub의 Agent HQ는 여러 에이전트를 통합하여 코드 품질을 보장하고 안정적인 워크플로우 운영을 지원해요.

• Agent HQ는 LLM, Tool, Guard 노드를 활용해 각 작업 단계를 분리 운영하며, 품질 점수화를 통해 자동 생성 코드를 철저히 관리해요.

• 일상적인 코딩 생산성을 높이고 싶다면 Cursor 2.0(Composer)을, 대규모 컨텍스트 처리가 필요하다면 Gemini 모델에 주목하는 것이 좋겠어요.

📖 자세한 내용 최근 GitHub에서 Agent HQ를 선보였어요. 에이전트 관리와 자동화에 관심 있는 분이라면, 여러 에이전트를 한곳에서 어떻게 운영하고 코드 품질을 보장할지 궁금하실 텐데요. GitHub이 갑자기 Agent HQ를 출시한 이유는 무엇일까요? 사실 여러 에이전트 간 워크플로우* 통합과 생성된 코드의 품질 평가, 그리고 외부 시스템과의 연동은 생각보다 까다로운 작업입니다. 특히 여러 에이전트를 서로 연결하고 워크플로우를 안정적으로 운영하며, API 연동이나 문서 검색을 위한 벡터 스토어* 연결 같은 부분에서 실무 난관이 많아요.

Agent HQ는 중앙 제어실 역할을 하며 여러 에이전트를 오케스트레이션하고 GitHub 내에서 워크플로우를 직접 관리할 수 있도록 설계되어 있어요. 특히 LLM 노드, Tool 노드, Guard 노드로 구성되어 있어 각 단계에서 모델 호출, 외부 도구 사용, 가드레일 적용을 분리해서 운영할 수 있어요. 또한 파일, 벡터 스토어, 웹 검색 기능을 통해 문서 검색과 컨텍스트 확보가 가능하고, 리뷰·테스트 기능과 **품질 점수화(policy·quality scoring)**를 적용해 자동 생성 코드가 프로덕션에 배포될 수 있도록 엄격하게 통제해요. 더 나아가 플랜 모드에서는 에이전트가 명확한 단계로 작업을 쪼개고 필요한 질문을 던져 진행 순서를 정의하며, 포맷된 지시문을 전송해 수행할 작업을 정확히 전달해요. 이와 함께 대시보드 지표와 개발자 레벨 관리 기능으로 누가 어떤 브랜치에서, 언제 병합 충돌을 처리했는지 추적할 수 있고, 퍼블리시 기능 → MCP로 서드파티 앱 연동 → 체킷으로 UI(위젯) 커스터마이징 같은 흐름으로 배포와 통합을 진행할 수 있어요. 웹·IDE·모바일·CLI 버전에서 에이전트를 할당·추적하고 원클릭으로 작업을 감독하거나 병합 충돌을 처리하는 기능까지 제공하며, 몇 달 내 출시 예정으로 기업용 대규모 에이전트화(multimodal agentic workflows) 전환의 핵심 단계가 될 것으로 보입니다.

비교 관점에서 보자면, 코딩 보조 쪽은 Cursor가 Cursor 2.0과 Composer 모델로 강력하게 부상하고 있어요. Composer 모델은 매우 빠르며 지능과 속도 면에서 기존 모델들을 능가한다고 주장하고, Composer 기반 모델은 200k 컨텍스트 윈도우를 제공해 대규모 코드·문서 작업에 유리합니다. 더불어 Cursor는 네이티브 브라우저 지원과 Chrome DevTools 통합으로 실전 코딩 환경에서 직접 수정·검증할 수 있게 해주죠. 한편 Google은 Gemini 3 Pro 프리뷰를 11월에 예고했고, 모델군을 특화된 토큰 윈도우와 일반 목적 모델로 구분해 제공할 계획이라 대용량 컨텍스트 처리가 중요한 워크로드에는 Gemini 계열이 더 적합할 가능성이 큽니다. 결론적으로 조직 단위의 에이전트 오케스트레이션과 프로덕션 배포를 목표로 한다면 Agent HQ가 추천되고, 일상적인 코딩 생산성 향상이나 대규모 코드 컨텍스트 처리가 필요하면 Cursor 2.0(Composer)을, 모델 연구나 대규모 컨텍스트 실험을 원한다면 Gemini과 향후 나올 Google의 이미지/모델 업데이트들을 주목하시는 것이 좋겠어요.

👤 AI LABS • 👁️ 8,458회

How to Start an AI Startup - 2026 (Step-by-Step Guide) AI Startup Roadmap

How to Start an AI Startup - 2026 (Step-by-Step Guide) AI Startup Roadmap

📋 3줄 요약

• AI 스타트업 창업은 도메인 지식과 사용자 문제에 대한 명확한 인사이트를 바탕으로 할 때 성공 가능성이 높아요.

• 초기 단계에서는 LLM 노드와 RAG 시스템을 활용해 제품 아키텍처를 구성하고, 빠르게 MVP 검증을 받아야 해요.

• 팀 구성은 엔지니어와 비즈니스 담당으로 시작해 초기 고객 피드백을 쌓은 후, 필요시 피벗을 준비하는 것이 좋답니다.

📖 자세한 내용 최근 AI Startup Roadmap 채널에서 How to Start an AI Startup - 2026을 선보였어요. AI 스타트업 창업에 관심 있는 분이라면, 언제 시작해야 하고 무엇부터 준비해야 하는지 궁금하실 텐데요. AI Startup Roadmap 채널이 갑자기 How to Start an AI Startup - 2026을 출시한 이유는 무엇일까요? 사실 제품/마켓 적합성을 찾고 팀을 구성하며 데이터와 모델을 동시에 다루는 일은 생각보다 까다로운 작업입니다.

이 가이드는 창업 초기부터 성장 단계까지 실제로 적용 가능한 구성요소와 실행 순서를 제시해요. 먼저 제품 아키텍처 관점에서는 LLM 노드, Tool 노드, Guard 노드 같은 구성 단위를 명확히 정의하고, 또한 파일, 벡터 스토어, 웹 검색 기능을 연결하는 방식이 핵심이에요. 더 나아가서는 RAG* 시스템과 임베딩을 활용해 파일 벡터 스토어에 연결하여 문서 검색과 컨텍스트 보강을 수행하고, API* 연동으로 외부 데이터와 결제·인증을 통합하는 흐름을 만듭니다. 또한 프롬프트 엔지니어링**을 통해 응답 품질을 개선하고 에이전트 패턴을 도입해 반복 업무 자동화를 구현할 수 있어요. 예시로는 파일에서 벡터 인덱스를 만들어 문서 검색을 제공하고, 고객 응대 챗봇 템플릿으로 환불/구독 해지 처리를 자동화하는 실제 워크플로우가 있고, 가드레일로 개인정보 유출 방지와 휴먼 어프루벌로 답변 검토를 넣어야 합니다. 도구 비교 관점에서 n8n은 약 500개 노드로 다양한 외부 연결을 빠르게 지원하는 반면 Agent Builder 계열은 상대적으로 적은 수의 노드(예: 5개)로 핵심 플로우에 집중하는 구조라는 차이가 있어요. 퍼블리시 기능 → 체킷 연동 → UI 커스터마이징 같은 실행 순서를 통해 프로덕트 배포와 위젯 내장까지 빠르게 진행할 수 있고, MCP로 서드파티 앱 연동하는 전략도 고려할 수 있습니다.

비교와 결론으로는, AI 창업은 도메인 지식과 사용자 문제에 대한 명확한 인사이트가 있을 때 가장 성공 가능성이 높아요. 더 나아가 추천하는 접근은 좁은 도메인에서 시작해 3–6개월 내에 RAG 기반의 MVP로 검증을 받고 초기 고객 피드백을 통해 제품을 다듬는 것입니다. 팀 구성은 엔지니어 1~2명과 프로덕트/비즈니스 담당 1명으로 시작해 초기 고객 레퍼런스와 핵심 지표(활성 사용자, 전환율)를 쌓는 것이 투자자 설득에 유리하고, 필요하면 피벗을 빠르게 할 준비를 하셔야 해요. 결론적으로 창업은 불확실성이 크지만 도메인 특화 문제로 시작해 문서 검색·자동화 같은 명확한 가치 제공으로 빠르게 검증할 수 있다면 도전할 만하다고 추천드립니다.

👤 Daniel | Tech & Data • 👁️ 8,153회

Is This the End of MCP for AI Agents?

Is This the End of MCP for AI Agents?

📋 3줄 요약

• MCP는 여전히 AI 에이전트의 툴 탐색과 문서 제공에 유용하지만, 실제 실행은 서버 쪽으로 이전하는 것이 더 현실적이에요.

• 에이전트의 툴 정의와 컨텍스트 관리가 복잡해지면서, Cloudflare 팀은 TypeScript API 래퍼를 사용해 필요소를 최소화하는 새로운 접근 방식을 제안했어요.

• MCP의 종말은 아니지만, 에이전트 프레임워크는 서버 기반의 보안과 프라이버시를 유지하며 효율성을 높이는 방향으로 진화하고 있어요.

📖 자세한 내용 최근 Enthropic에서 새로운 blog post를 선보였어요. MCP와 AI 에이전트 관리에 관심 있는 분이라면, MCP가 에이전트 구축 방식에서 계속 유효한지 궁금하실 텐데요. Enthropic이 갑자기 blog post를 공개한 이유는 무엇일까요? 사실 에이전트의 툴 정의와 컨텍스트 관리 문제는 생각보다 까다로운 작업입니다. MCP* 설계는 이론적으로는 깔끔했지만 실제로는 관리 복잡도와 컨텍스트 부하 때문에 한계가 드러났고, 두 개의 MCB가 연결된 간단한 예만으로도 이미 거의 20**,000 tokens***가 소모되어 전체 컨텍스트의 약 10%를 차지하는 등 관리가 곧 골칫거리로 바뀌는 경우가 많아요.

또한 구체적으로 보면 문제는 두 가지로 모입니다. 첫째, 모든 툴 정의를 미리 컨텍스트에 주입하면 정의 오버로드로 인해 컨텍스트가 비대해지고 중간 결과(intermediate results)가 계속 전송되며 실행 코드가 누적되어 ‘rot’가 발생합니다. 더 나아가 영업 회의 같은 긴 대화록을 예로 들면 50,000 토큰 규모의 텍스트를 도구가 읽어오는 식으로 불필요한 데이터 전송이 발생할 수 있어요. 이에 대해 Cloudflare 팀은 MCP를 그대로 LLM 노출 인터페이스로 쓰기보다 TypeScript로 변환한 API 래퍼**를 서버 쪽에 두어, 복잡한 툴들은 서버에서 조회·가공하고 필요한 호출만 연결하도록 했습니다. 또한 이 방식은 여러 호출을 연결(catenate)하거나 체인으로 묶을 때 유리하고, 툴 검색 기반으로 필요한 명령(grip commands)만 찾아 실행하게 하여 에이전트 컨텍스트의 bloat를 줄입니다. 더 나아가 동적 격리 실행(dynamic isolate sandbox)을 도입해 실행을 외부로 분리하고 PII를 전송하기 전 익명화하는 등 프라이버시 보존과 권한 최소화를 가능하게 합니다. 여기에 progressive disclosure 방식으로 필요한 정의만 그때그때 로딩하고, stateful persistent skills를 통해 영구적인 상태·기능을 관리하는 접근이 제안됩니다.

비교하면 MCP는 완전히 쓸모없어진 것이 아니라 역할이 재정의되는 모습이에요. MCP는 여전히 툴 탐색과 일관된 스키마·문서 제공에는 유리하지만, 툴의 실제 실행·연결·인증은 서버 쪽(TypeScript 래퍼나 워커)으로 옮기고 RPC*와 문서화된 인터페이스로 노출하는 편이 현실적입니다. 따라서 권장되는 설계는 MCP를 ‘발견(discovery)·문서화’ 계층으로 유지하되, 실행은 격리된 서버 샌드박스에서 수행하고 필요 시에만 정의를 점진적으로 주입하는 것입니다. 요약하면 MCP의 종말은 아니지만, 에이전트 프레임워크는 컨텍스트 로딩을 최소화하고 서버 기반의 연결·인증 표준을 도입하며 샌드박스와 익명화로 보안·프라이버시를 지키는 방향으로 나아가는 것이 더 나은 선택이에요.

👤 Prompt Engineering • 👁️ 8,066회

AI Tools For Content Creation | Best Options For Modern Creators ? (Honest Review)

AI Tools For Content Creation | Best Options For Modern Creators ? (Honest Review)

📋 3줄 요약

• VoxDeck은 AI 기반의 프레젠테이션 빌더로 빠르고 시각적으로 매력적인 발표 자료 제작을 지원해요.

• 템플릿, 3D 차트, 애니메이션 등의 다양한 기능을 통해 사용자 생산성을 높이고 포인트 시스템으로 사용자 참여를 유도해요.

• 복잡한 디자인이나 보안이 필요한 환경에서는 전통적인 도구와 병행하는 전략을 추천해요.

📖 자세한 내용 최근 VoxTech에서 VoxDeck을 선보였어요. AI 기반 콘텐츠 제작 도구에 관심 있는 분이라면, 어떤 도구가 프레젠테이션·영상·포스트 제작을 가장 효과적으로 도와줄지 궁금하실 텐데요. VoxTech이 갑자기 VoxDeck을 출시한 이유는 무엇일까요? 사실 짧은 시간 안에 시각적으로 매력적인 발표 자료를 만드는 일은 생각보다 까다로운 작업입니다. 또한 기존의 슬라이드 워크플로우와 달리 AI 도구는 프롬프트* 기반의 입력과 자동화된 워크플로우*를 결합해 반복 작업을 줄여주지만, 그만큼 설정과 연동을 고려해야 해요.

VoxDeck은 프레젠테이션 빌더 기능을 중심으로 템플릿 선택, 3D 차트 적용, 세련된 애니메이션, 아바타 기반의 비주얼 포맷을 제공해 시각적 완성도를 빠르게 높여주는 방향을 택하고 있어요. 또한 포인트 시스템과 리워드 모델을 도입해 사용자가 활동이나 업로드로 포인트를 얻어 특정 기능을 잠금 해제하거나 리소스를 확보하는 구조를 제시하고 있고, 피치덱, 가상 세션, 비즈니스 프레젠테이션 등 구체적 사용 사례를 목표로 삼고 있어요. 외부 데이터나 서비스 연동은 API를 통해 확장이 가능하고, 자동화된 콘텐츠 재가공이나 반복 작업 처리를 위해 에이전트 형태의 자동화 설정을 활용할 수 있다고 설명합니다. 파일 업로드 후 템플릿 적용, 3D 차트·애니메이션 조정, 아바타·비주얼 포맷으로 출력하는 식으로 작업 흐름을 단축하는 방식이 핵심이에요.

전통적인 슬라이드 툴과 비교하면 VoxDeck은 시각적 요소와 생산성 향상에 초점이 맞춰져 있어 빠른 제작과 청중 참여 유도에 유리합니다. 더 나아가 복잡한 커스터마이징이나 고도의 디자인 제어가 필요하거나 온프레미스 보안·데이터 거버넌스가 우선이라면 기존 툴과 별도 워크플로우를 유지하는 편이 낫겠죠. 비용과 성능 관점에서는 내부적으로 사용하는 언어 모델 호출 비용이나 처리량이 토큰* 단위로 산정될 가능성이 있어 사용 패턴에 따라 비용 구조를 검토해야 해요. 결론적으로 빠르고 시각적인 발표 자료를 자주 만들며 보상형 포인트 모델과 아바타·애니메이션 기능을 활용하고 싶다면 VoxDeck이 매력적이며, 세밀한 디자인 통제나 온프레미스 보안 요구가 큰 환경에서는 전통 툴과 병행하는 전략을 권장합니다.

👤 Future AI • 👁️ 8,047회

매일 새벽 1시, AI 트렌드를 놓치지 마세요!

이런 유용한 AI 요약을 매일 이메일로 받아보세요